Vamos a hablar de SEO. Concretamente, del SEO que ya se está haciendo a nivel profesional, y que se va a seguir haciendo a niveles más amplios durante los próximos años 2018, 2019, etc…. Pan comido. Aprenderemos vocabulario SEO como: Device action, Visit-in-person, SERP Features y funcionalidades de SERP, featured snippets, Dwell Time, Pogosticking… Vamos al lío!

Cómo y por qué evoluciona Google.

Antes de nada, que conste que yo soy el primer escéptico cuando me encuentro un post del tipo “Las claves esenciales del SEO en 2018”. Las claves del SEO en 2018 son las mismas que las de 2017, y casi seguro serán iguales en 2019.

Ahora, si cogieras a un tío con conocimientos medios de SEO en 2012, y lo pusieras directamente a vérselas con Google en 2018, estaría bastante perdido.

Haría cosas como crear tantas páginas como keywords quisiera posicionar, aunque cambiasen sólo en una palabra (sí, haciendo barbaridades como una URL para “hoteles-madrid” y otra para “hoteles-en-madrid”). O spamearía alegremente foros y blogs de casi cualquier temática.

Entonces, ¿en qué quedamos? ¿El SEO cambia o no cambia? A los SEOs nos gustaría que no, y pasarnos años repitiendo una y otra vez las técnicas que nos han funcionado en el pasado.

Pero Google sí cambia. Unas 500 veces al año, para ser preciso (y cada año, al menos cuatro o cinco de estos updates son de los “gordos”). Vale, no tan gordos como para que el SEO pase a ser irreconocible de 2017 a 2018. Pero sí como para que el juego evolucione mucho de 2012 a hoy en día.

Haz los cálculos. Unos 20 updates de los gordos desde la introducción de Hummingbird en agosto de 2013.

Por esta lógica, en 5 años el SEO podría ser irreconocible. Quizá el 90% del tiempo de un SEO se emplee en optimizar cosas para las que hoy apenas tenemos herramientas adecuadas: PWAs, búsquedas por voz, Siri y Google Home, Alexa skills…

¿Por qué cambia Google? Sobre todo por 3 razones:

- Para adaptarse a los gustos de los usuarios. Los hábitos de uso cambian y las expectativas también. Hace cinco años, nadie en su sano juicio esperaba recibir, al buscar con su móvil, una respuesta rápida (en menos de 3 segundos) a cualquier consulta y sin mediar más de un clic. Hoy es lo normal. Google tiene que estar a la altura de lo que esperan unos usuarios cada vez más impacientes, si no quiere perder cuota de mercado.

- Para que no se cuelen resultados “spam” o que no lo “merecen” en los rankings. Esta es la clásica lucha entre la comunidad SEO (más o menos black hat) y Google. El objetivo de Google es dar al usuario el resultado más relevante para lo que está buscando; no el que mejor cumpla un checklist de requisitos SEO. Por eso, sus ingenieros trabajan para lograr algoritmos menos manipulables y más capaces de responder con precisión a lo que busca el usuario.

- Para rastrear e indexar la web con mayor eficiencia. Internet crece a un ritmo vertiginoso y eso es un desafío técnico para Google. Piensa en estos dos datos: cada minuto se crean miles de nuevas páginas webs en el mundo, y cada día se hacen unos 500 millones de búsquedas nuevas en Google, que nunca antes se habían hecho (el 15% de las búsquedas se hacen por primera vez). Vale que Google tiene una capacidad de rastreo, análisis e indexación brutal, pero todo lo que sea ahorrar recursos es bueno para ellos. Porque reducen costes y así mantienen la brecha respecto a los demás. A Google le aterroriza que aparezca un competidor con una tecnología más lean que la suya. Por eso, deben seguir innovando para marcar el ritmo.

En principio, los que nos interesan más son los motivos 1 y 2, y de ellos voy a hablar en la mayoría de este post.

El tercer motivo está detrás de casi todos los updates rutinarios, los que se hacen a razón de uno al día o más, y que normalmente no causan grandes terremotos en los rankings.

Pero no subestimes el afán de “eficiencia” y dominación de Google, que en el fondo está detrás de los problemas para renderizar gran parte de las webs hechas con Javascript, o detrás del proyecto AMP, del que vamos a hablar un poco en este post.

Intención de búsqueda.

Volvamos a Hummingbird, inicio de la era “moderna” de Google. Una de las novedades de este algoritmo era tratar de “comprender” las búsquedas de los usuarios.

Frente al modelo anterior, que tomaba las búsquedas como una mera suma de términos, y devolvía documentos en los que esos términos aparecieran de la manera más relevante posible (si era en las metas, mejor que una simple mención en el texto).

Hummingbird fue el principio, pero lo de la comprensión de la query se redondeó con Rankbrain (finales de 2015), el algoritmo machine learning de Google.

A partir de ese momento, Google es perfectamente capaz de entender que si metes en la cajita de búsqueda“campeón de liga 2002/03” quieres saber qué equipo ganó la liga española de fútbol en la temporada 2002-2003. Y como lo sabe, responde directamente que fue el Real Madrid, no se limita a sacar 10 resultados de otras webs con datos de esa liga. Pruébalo.

Atención aquí: los términos que he puesto en negrita no estaban incluidos en la búsqueda original.

Eso es un contexto, que Google extrae de los millones de datos que tiene almacenados en sus logs.

Basado en esos datos, sabe que cuando alguien busca esto, en español y en España, está preguntando por fútbol y por la liga española, no por waterpolo o por la Premier League. Cuestión de volumen, y de adaptarse a lo que busca la aplastante mayoría.

Ahora, ¿para qué trata Google de comprender las búsquedas que hacemos? Para dar un resultado mejor, sí… Pero, ¿es eso escalable? ¿No hemos dicho que cada día hay 500 millones de búsquedas nuevas?

Cuando trabajas con miles de millones de datos, la única solución para hacerlo manejable es identificar patrones y segmentar de acuerdo a ello.

Estos patrones son las distintas intenciones de usuario (user intent) o como yo prefiero decir, intenciones de búsqueda.

Sabemos que Google divide las búsquedas en 6 grupos según su intención, porque lo pone bien clarito en la última edición de sus Quality Evaluator Guidelines, un documento interno para fijar los criterios de sus “beta testers”.

Estas 6 intenciones son:

- Know (saber, investigar un tema en un sentido amplio)

- Know simple (mucho más específico: encontrar un dato concreto, una imagen, etc)

- Do (hacer algo)

- Device action (hacer algo con uno de nuestros dispositivos: móvil, Google Home, etc)

- Website (búsquedas de navegación, ir a una página o sitio concreto)

- Visit-in-person (buscar direcciones, negocios cerca de una ubicación concreta)

Si Google sabe de antemano lo que pretende el usuario al hacer una consulta, puede preparar una SERP tipo, adecuada para esa intención.

SERP Features o funcionalidades de SERP.

La SERP es la página de resultados de Google. ¿Hay SERPs diferentes según la búsqueda? Sí, claro.

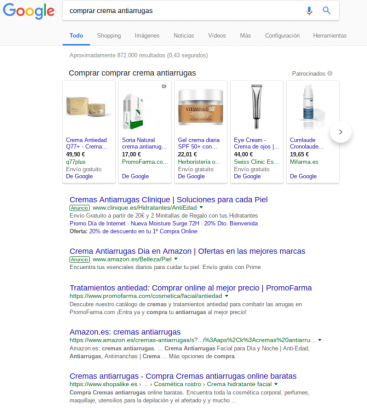

Incluso para búsquedas a priori muy similares, las SERPs pueden tener un diseño y un contenido muy distinto. Busca “mejores cremas antiarrugas” y “comprar crema antiarrugas” y lo verás.

¿Cómo se llaman las “piezas” que usa para hacer unas SERPs diferentes de otras? Son los SERP features o funcionalidades de la SERP .

Incluyen cosas como:

- los módulos de Adwords

- el módulo de Google Shopping

- el módulo de imágenes

- los fragmentos destacados (featured snippets)

- los resultados destacados de vídeo

- el carrusel de noticias destacadas…

Es casi imposible listarlos todos, porque en los últimos meses Google ha ido añadiendo nuevas funcionalidades y no deja de “experimentar” con nuevos features. Incluso llegó a experimentar con una SERP que tenía cero resultados orgánicos, aunque sólo durante unos días.

Cómo mide Google esto: CTR y dwell time / pogosticking.

Vamos a lo práctico: ¿cómo te afecta que Google esté mostrando ciertos features en las keywords de tu nicho o las que trabajas habitualmente?

Si el fin de Google es responder de la manera más rápida y directa a las búsquedas, y si cada vez muestra más SERP features de estos, será porque responden mejor a lo que quiere el usuario.

Por ejemplo, si buscas un negocio local, el módulo del mapa es lo primero que vas a mirar, está claro. Llama mucho más la atención que el resto de resultados y features que aparecen en una query local.

Pero todo esto, Google lo podrá saber con datos medibles, ¿no? ¿Qué métricas tiene para saber si un resultado concreto responde bien a lo que busca el usuario?

Una la conoces seguro, el CTR. Las otras dos son un poco menos comunes: dwell time y pogosticking (perdón por los anglicismos).

CTR

El CTR es sencillamente las veces que un resultado recibe clics, dividida entre el número de impresiones totales que ha recibido en las SERPs. Es una métrica que podemos conocer para nuestros resultados, gracias a Search Console, pero desgraciadamente no podemos saber el CTR de la competencia.

¿Qué es un buen CTR y qué sería uno malo? Depende mucho. Para una búsqueda de marca, los resultados de esa marca deberían llevarse sin problemas un CTR de entre el 50% y el 80%.

Para búsquedas genéricas, no de marca, el CTR de un Top 1 orgánico ronda entre el 20% y el 30%.

Pero hay más. La presencia de determinados SERP features hace bajar de manera drástica el CTR de los resultados orgánicos.

Por ejemplo, el “temido” módulo de Google Shopping que suele salir en primera posición para búsquedas comerciales, como la de “comprar crema antiarrugas” que vimos antes. Cuando aparece, causa estragos en el CTR de los resultados orgánicos que hay debajo, que para colmo suelen estar sepultados bajo 2 bloques más de Adwords.

En una SERP así, la posición verdadera del Top 1 orgánico es como un Top 4, si no hubiera Shopping ni Adwords.

Pero los SERP features no siempre son malos para nuestro CTR.

Si Google nos otorga un featured snippet, o un resultado con thumbnail, o con vídeo, nuestro CTR se dispara por las nubes. Y al revés: si se lo da a la competencia y a nosotros no, nuestro CTR se deprime, aunque estemos por encima de ellos en posición.

(Para los impacientes, más adelante vamos a ver qué puedes hacer para llevarte los SERP features “buenos”).

¿Cómo sé con seguridad que Google está analizando el CTR para saber si debe introducir cambios en una SERP, tanto cambios de ranking en los resultados orgánicos, como cambios en los features?

Hombre, certezas en el SEO hay pocas. Pero te cuento el descubrimiento que hice con el reciente update de marzo.

En pocas palabras, los datos (no sólo los míos) mostraban que en las semanas anteriores al update Google jugó a poner las SERPs patas arriba, probando en las posiciones más altas resultados que antes ni entraban en el Top 100, y viceversa.

Tras este bailecito que duró de 3 a 6 semanas, según la query, entre el 7 y el 11 de marzo reordenó de manera ya estable la SERP, supuestamente de acuerdo a los nuevos criterios programados en el update.

Hubo resultados Top 1 que volvieron a su posición original, y otros que se quedaron algunos puestos por debajo. Lo que comprobé con datos de mis webs es que si el CTR del resultado era bueno (recuerda: bueno, es por encima del 30%), siempre volvía a ocupar el Top 1 tras el update.

De lo que se puede concluir que ninguno de los otros resultados rindió con un CTR mejor durante las semanas de prueba.

Pero espera, que hay más. Encontré una serie de resultados excepcionales, que tenían CTRs increíblemente altos (hablo del 40% para arriba, con casos incluso del 70% y no eran búsquedas de marca).

¿Qué más tenían estos resultados de particular? Algo muy interesante: Google no los había sometido al bailecito previo. Se quedaron inamovibles en el Top 1 a lo largo de las semanas previas al update.

Conclusión: los datos de Google dicen que ciertos CTRs son imposibles de superar, por lo cual en esa SERP no necesita hacer mejoras, y nada cambia. El principio de darle lo que quiere al usuario, junto con el de la eficiencia y ahorrar recursos.

Ahora, veamos eso del dwell time y pogosticking.

Dwell Time y Pogosticking.

Son dos caras de la misma moneda: el “rebote” dentro de los resultados de una SERP.

Si buscas algo y haces clic en un resultado que no te satisface del todo, pueden pasar dos cosas:

- que vuelvas a la SERP y hagas clic en otro resultado (esto es el POGOSTICKING)

- o que pases un tiempo allí hasta que vuelvas a la SERP y hagas una nueva búsqueda, afinando más con los términos.

En ambos casos, Google consideraría que el clic hacia el primer sitio ha acabado en rebote, pero la diferencia está en el dwell time, el tiempo que te has quedado en el primer resultado.

¿Un dwell time bajo siempre es algo malo? No tiene por qué.

Si estás buscando un resultado muy concreto (recuerda: intención de búsqueda Know Simple), como por ejemplo el número de teléfono de un negocio, entrarás en el resultado, encontrarás el dato que buscas y cerrarás esa pestaña. Intención de la búsqueda cumplida y todos contentos.

Durante años, ha habido negocios millonarios viviendo de este tipo de información “simple”, con cero permanencia del usuario en la web, y ahí han estado, en lo más alto de Google.

Pero cuidado, porque ahora Google está sustituyendo a estos negocios, uno tras otros, con sus propias respuestas directas. Todo queda en casa… dentro del buscador.

Featured snippet o fragmento enriquecido

Queda otra funcionalidad de SERP que puede disparar tu CTR. El featured snippet, con o sin imagen, es la “caza mayor” de los resultados especiales.

¿Cuándo se muestra? En palabras de Google, “cuando reconocemos que una consulta solicita respuesta a una pregunta, detectamos mediante programación las páginas que pueden responder a dicha pregunta y mostramos un fragmento destacado”.

Aunque Google asegura en la misma página que no existe un método para pedir que se muestren, lo que mejor funciona es responder a una pregunta de forma clara y directa justo debajo de un encabezado en el que se formula la pregunta.

Herramientas SEO para trabajar con intención de búsqueda y SERP features.

Hemos visto muchas cosas, pero queda por ver un tema importante para el tráfico móvil y que además genera mucho debate: el dichoso AMP.

AMP es un formato de HTML “ultraligero” con el que Google se ha puesto bastante pesado, todo con el fin de conseguir una carga más rápida, adecuada para conexiones 3G.

El punto que quizá gusta menos es que, una vez que Google encuentra tus páginas en AMP válido, las guarda y las sirve íntegramente desde su caché, reduciendo mucho el tiempo de carga para el usuario final. Pero eso no quiere decir, ni mucho menos, que Google te esté “robando” tráfico.

A pesar de que está visible en las SERP móviles desde septiembre de 2016, AMP tiene todavía muchos detractores, especialmente en la comunidad SEO.

Yo soy un tío práctico y creo que si Google se empeña en instaurar algo, tiene poco sentido discutir sobre si es bueno o no. Es mejor pasar por el aro, y medir los pros y los contras después de haber experimentado con ello.

Yo lo tengo activo en varios proyectos, incluido mi blog personal, y estas son mis impresiones:

Pros:

- Aumenta tu visibilidad y CTR desde móvil, eso no se puede negar. Vale, aumenta más si estás en nichos en los que importa que el resultado sea reciente, gracias al carrusel de noticias destacadas. Para diarios y grandes medios, por ejemplo, hay que estar loco para no implementar AMP. Por otro lado, no hay que olvidar que la mayoría de nichos ya reciben más tráfico desde móvil que en desktop.

- Hay un claro coste de oportunidad por no activarlo, si tu competencia sí lo tiene. Es como lo de los SERP features que te roban CTR. Tu competencia, con AMP, te va a quitar más CTR que antes, no lo dudes. Si tú lo pones, al menos equilibras las tablas de nuevo.

- Quizá el mayor pro: con AMP estarás totalmente a salvo de bajadas de tráfico con el update de velocidad de carga móvil del 1 de julio. ¿Tu versión móvil es lenta? Pones AMP y te olvidas.

Contras:

- Si monetizas con Adsense y plataformas de publicidad, podría bajar tu tasa de conversión (clic en los anuncios). Pero esto no va pasar necesariamente. De hecho, pienso que hay más prejuicio contra AMP que verdaderos datos que lo demuestren.

En primer lugar, AMP y Adsense sí son compatibles, y es posible añadir Adsense a tus páginas en AMP y retener el control sobre los tipos y formatos de anuncios que muestras, a un nivel similar al que tienes con Adsense de toda la vida. Entonces, no hay razón por la que tu versión AMP no pueda mostrar los mismos anuncios que tu versión html normal, y convertir al mismo nivel.

Otra cosa es que el tráfico que va a AMP sea un tipo de usuario poco dado a convertir, lo que es muy probable si hablamos de búsquedas Know Simple, en los que la intención se resuelve con el contenido principal de la página, y hay poco incentivo para hacer clic en la publicidad.

Pero eso no tiene nada que ver con AMP, y también tendrías una tasa baja de conversión si solo tuvieras la versión html normal.

Conclusión SEO

Pues llevo casi 3000 palabras y siento que me estoy dejando un montón de cosas fuera. Cómo van a cambiar el panorama las PWAs, las entidades, la búsqueda por voz (un 50% de las búsquedas serán por voz en 2020) o los dispositivos tipo Google Home (un solo resultado, quédate con eso)…

Pero tengo que cerrar. Espero que de este post hayas sacado en claro dos conceptos: Google va entendiendo y tratando de forma más granular las búsquedas y la intención del usuario, y eso se traduce en SERP features y rich results que podemos (debemos) usar para aumentar nuestro tráfico orgánico.

El CTR orgánico es el mejor indicador de que lo estamos haciendo bien (analizado por búsquedas, no el global de un sitio, que eso es muy confuso).

Y también es un excelente indicador el hecho de que Google nos vaya asignando más rich results y fragmentos enriquecidos. Esto es perfectamente trackeable con las herramientas SEO a nuestra disposición, y me parece más útil a día de hoy que trackear posiciones sin más.

Si te han surgido preguntas o dudas, no dudes en escribirme en los comentarios 😉 ¡Hasta la próxima, lector!